Die KI-Software ChatGPT wurde Ende November 2022 von der Firma OpenAi für die Öffentlichkeit freigegeben. GPT steht für Generative Pre-trained Transformer, was so viel wie eintrainierter Texte-erzeugender Transformator heißt. Im Vergleich zu bekannten Chatbots, beispielsweise als Service auf Webseiten, kann ChatGPT vollständige Texte ausarbeiten, die in sich weitgehend konsistent sind. Dabei greift die Künstliche Intelligenz (KI) auf Nachrichtenartikel, Soziale Medien, Foren oder Bücher im Internet zurück. Wir haben Prof. Peter Kabel von der Fakultät Design Medien Information im Fachgebiet Interaction und Service Design befragt, was ChatGPT unter anderem für die zukünftige wissenschaftliche Arbeit bedeutet.

Lieber Professor Kabel, was genau kann die neue KI „ChatGPT“ und was unterscheidet sie von herkömmlichen Chatbots?

Prof. Peter Kabel: Es handelt sich um grundlegend verschiedene Systeme, die – etwas missverständlich – den Begriff „Chat“ teilen. Das derzeit so gehypte ChatGPT ist ein Interface für das dahinterliegende Sprachmodel GPT von OpenAI. Mithilfe des Chat-Interface kann man dieses enorm leistungsfähige Sprachmodel befragen und erhält sehr detaillierte und – zumindest auf den ersten Blick – plausible Antworten. „Herkömmliche Chatbots“ basieren in der Regel auf viel kleineren Wissensdomänen. Aus gutem Grund beantwortet der Chatbot auf einer Website nur Fragen, die im Zusammenhang des Internetangebots relevant sind, und verweigert die Antwort auf Anfragen außerhalb dieses klar umrissenen Feldes. So vermeidet ein herkömmlicher Chatbot – was bei ChatGPT regelmäßig passiert, – dass das Sprachmodel in unterschiedlicher Weise übers Ziel hinausschießt und viel zu lang ist, ausufernd, oder gar vollkommen halluziniert. Letzteres bedeutet, dass das Model beispielsweise Quellenangaben und Fakten erfindet, die nicht existieren.

Jede KI beruht auf den Daten, mit denen diese programmiert wurde und unterliegt einem Algorithmus. Wie können systematische Fehler beim ChatGPT vermieden werden?

Peter Kabel: Man kann der KI „Manieren beibringen“. Aufgrund der unendlichen Datenmengen und ausufernden Themenfelder sind die möglichen Fehler ebenfalls unendlich. Das Einhegen dieser Fehler wäre die Aufgabe von Menschen. Entweder durch systematische Testroutinen und Korrektur, und – oder – indem man das Nutzer*innen-Feedback systematisch auswertet und in die Korrektur einbezieht. Beides ist sehr aufwändig und kann dazu führen, dass das ganze Vorhaben die derzeitigen Machbarkeitsgrenzen überschreitet und sich jeder Ökonomie entzieht. Man muss bedenken, dass es unterschiedlichste Arten von Fehlern gibt. Dinge, die faktisch falsch sind, oder schlicht frei erfunden. Eine Fehlerart, die in einer großen Zahl von ChatGPT-Antworten zu bemängeln sind.

Daneben gibt es aber auch eine unendliche Anzahl von „weichen Fehlern“. Fehlern, die im besten Fall einfach nicht vernünftig sind, oder – im weniger günstigen Fall – ethisch, moralisch, kulturell und so weiter verwerflich. Selbst wenn man anerkennt, dass der Begriff Intelligenz nicht eindeutig definiert ist und mithin auch künstliche Intelligenz nicht klar definiert ist, muss man konstatieren, dass Systeme wie ChatGPT eben überhaupt nicht intelligent sind. Sondern sie sind im Gegenteil ziemlich „dumm“, weil entscheidende Fähigkeiten zur Unterscheidung zwischen richtig und falsch, sinnvoll und sinnlos und Fragen in Bezug auf Kultur und Ethik nicht vorhanden sind. In der Regel ist es das „Anthropomorphismus“ genannte Phänomen, das uns Menschen in Gegenständen der Natur oder Technik „Wesen“ erkennen lässt und uns glauben macht, Systeme wie ChatGPT hätten menschliche Intelligenz, und womöglich eigene Empfindungen.

| Forschung

Neue KI

ChatGPT: Disruptive Veränderungen erwartet

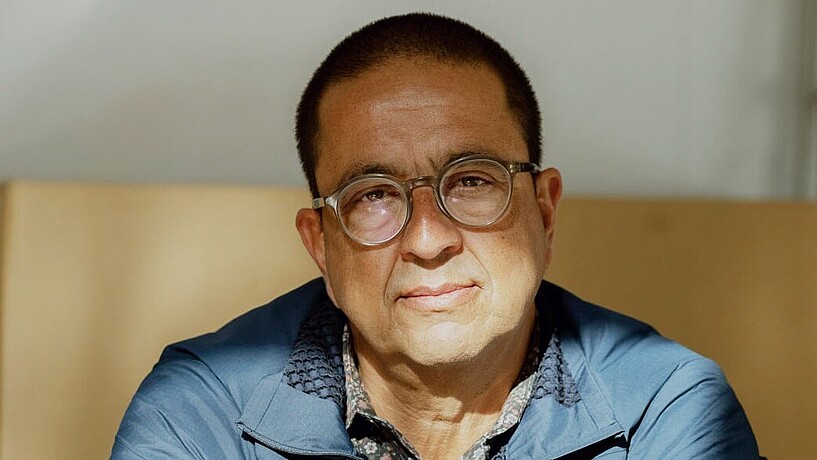

Prof. Kabel ist Experte für Interaction und Service Design am gleichnamigen Department Design.

Contact

Fakultät Design, Medien, Information (DMI)

Department Design

Prof. Peter Kabel

Experte für Interaction und Service Design

peter.kabel (at) googlemail (dot) com